Обзор

Рынок ИТ: итоги 2009Обзор подготовлен

Изобретения, которых не дождался ИТ-рынок

В конце 90-х - начале 2000-х аналитики и ученые прогнозировали бурное развитие существующих на тот момент технологий и появление Web3.0, новых видов компьютеров, полноценной виртуальной реальности. Несмотря на то что прогнозы эти не оправдались, определенные достижения в этих областях есть.

То что давать прогнозы — дело неблагодарное, это понимают все аналитики, поэтому они стараются, как минимум, не ставить конкретных дат для тех или иных предполагаемых технологических свершений. Но все-таки в появлении некоторых инноваций к концу первого десятилетия нового века они были уверены — или почти уверены.

Сетевая революция: путь первый

В конце 90-х гг. и начале 2000-х делались прогнозы, что вскоре произойдет революция, аналогичная той, которую произвел интернет, что появятся сети, трансформирующие, расширяющие, а возможно, и заменяющие World Wide Web. Например, сформируется семантический интернет (его также называют Web 3.0), получат широкое распространение grid-технологии.

В 2001 году создатель всемирной паутины Тим Бернерс-Ли заявил в журнале Scientific American, что в ближайшие десять лет семантическая паутина произведет такую же революцию в интернете, как в свое время произвела World Wide Web. "Уже сейчас мы можем наблюдать первые успехи семантического подхода, который может использоваться для автоматического обнаружения веб-сервисов и построения цепочек бизнес-процессов "на лету", но, как доказывает история, революция наступит только тогда, когда значительное количество пользователей и авторов ресурсов будет использовать технологии Semantic Web в своей работе", - прокомментировал свое заявление Тим Бернерс-Ли. Как видно, эта структура должна была "вырасти" из "обычного" интернета.

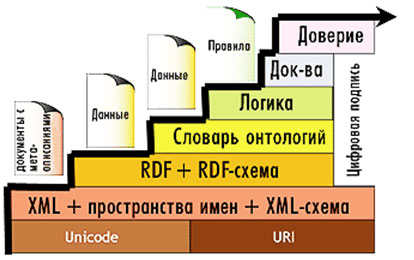

Смысл семантического интернета заключается в том, что компьютеры должны понимать смысл, значение документов и данных. Если всемирная глобальная паутина в первую очередь связывает все со всем и находит необходимые данные, наборы символов, то семантическая сеть будет обрабатывать информацию не только как данные, но и как знания. То есть это попытка создания и использования искусственного разума. Чтобы машина имитировала человеческий разум, Бернерс-Ли предложил снабдить веб-страницы некоторым количеством компьютерно-ориентированных данных (tags), а также создать документы, которые предназначены исключительно для компьютеров. Таким образом, компьютеры смогут понимать смысл семантических данных, следуя по гиперссылкам, ведущим к определениям ключевых терминов и правилам логических рассуждений о них. Данная инфраструктура станет отправной точкой для разработки автоматизированных веб-сервисов. Схему работы семантического интернета назвали "пирогом Бернерса-Ли".

"Семантический пирог" Бернерса-Ли, 1999

Источник: teacode.com, 2010

Однако есть много сомнений в том, что удастся полностью создать Semantic Web. В 2006 году их высказывал, например, директор по поиску компании Google Питер Норвиг: "Я не против Semantic Web. Но с точки зрения Google, к этому есть ряд препятствий, и главное из них - некомпетентность пользователей. Вторая проблема – счетчики статистики. И третье - жульничество. Если у нас будет семантический интернет без человеческого контроля, то мы будем гораздо более уязвимы для мошенников".

До сих пор семантическая паутина находится в разработке, и 99% сайтов пока не охвачено семантическим интернетом. Но тем не менее попытки развить эту сеть продолжаются. Например, Министерство экономики Германии в октябре 2007 года приступило к проекту "Тесей" - семантической модернизации немецкоязычного интернета за пять лет. Бюджет проекта - 180 млн евро.

Сетевая революция: путь второй

Другая сеть, предполагающая всемирное объединение компьютеров — это grid. В начале 2000-х гг. делались громкие заявления, что вскоре произойдет трансформация WWW в WWG (World Wide GRID — всемирную grid-сеть). Согласно определению авторов данной концепции, американцев Яна Фостера и Карла Кессельмана, "grid — согласованная, открытая и стандартизованная среда, которая обеспечивает гибкое, безопасное, скоординированное разделение ресурсов в рамках виртуальной организации". Grid-среда способна виртуализировать процессоры, память и коммуникации и обещает превратить все компьютерные ресурсы мира в, условно говоря, огромный мультипроцессор, который обладает почти неограниченными вычислительными возможностями. То есть это сеть, объединяющая компьютеры по всему миру и использующая их ресурсы для выполнения различных вычислений (так как большинство компьютеров используется не на полную мощность и не круглые сутки). Соответственно, "свободные" компьютерные ресурсы можно использовать - в перспективе — в любом конце света. По мнению создателей сети, собственников компьютерных ресурсов должно привлечь резкое увеличение производительности. В идеале все это может происходить бесплатно, в форме взаимозачета: то есть сегодня один пользуется свободными ресурсами другого, а завтра второй - ресурсами первого. Но, конечно, необходим контроль этих процессов.

Пока что grid-системы используются лишь государственными, научными, военными организациями по всему миру - примером может служить европейский проект EGEE, который обслуживает пользователей Большого адронного коллайдера, создаваемого в Европейской лаборатории по физике частиц в Женеве (CERN). Объединить ПК, реально стоящие на столах у пользователей, по мнению экспертов, пока невозможно, и одна из важных проблем — отсутствие единых для всех стандартов.

Компьютеры будущего еще не дождались своего часа

Вариантов замены ныне существующих кремниевых компьютеров предполагается четыре — квантовый компьютер, оптический, био- и молекулярный. Хотя с предсказаниями насчет этих инноваций ученые и просто интересующиеся были осторожнее, чем с сетями, тем не менее, ожидалось, что хотя бы какой-нибудь из этих видов начнет выпускаться к 2010-2015 гг. А журналисты специализированных изданий в течение этих 10 лет гадали, какая же из технологий будет первой. Пожалуй, только биокомпьютер отодвигался на неопределенно отдаленное будущее.

Работа квантовых компьютеров основывается на принципах квантовой механики — объекты в ней одновременно могут занимать несколько положений. Считается, что именно благодаря этой особенности применение таких компьютеров позволит добиться значительных успехов во многих областях по сравнению с классическими компьютерными технологиями. В 2001 году ученые из исследовательского центра IBM создали действующую модель квантового компьютера, который смог решить задачу: он понял, что 5×3=15. Эта простая задача была самым сложным вычислением за всю историю квантовых компьютеров, но ее решение дало надежду на изобретение машины, выполняющей за считанные часы вычисления, на которые у классических компьютеров уйдут столетия. В 2009 году ученым из Национального института стандартов и технологий в США впервые удалось собрать простейший программируемый квантовый компьютер. Точнее, они создали квантовый процессор с использованием стандартных технологий производства полупроводниковых чипов и протестировали его: доля ошибок в вычислениях составила 20% (для нормальной работы компьютера необходима доля 0,01%). Однако создатели подчеркивают, что их процессор должен стать важной частью будущего полноценного квантового компьютера. Но пока что это все. А в 2000 году СМИ писали, что, по оценкам ученых, прототипы квантовых компьютеров могут появиться уже в 2005 году, и в 2010-2020 гг. должно начаться их массовое производство.

С оптическим компьютером ситуация почти обратная. Несмотря на то, что к началу 21 века были уже достаточно хорошо отработаны технологии производства основных компонентов оптического компьютера (IBM разработала голографическую память, OptiComp - оптоэлектронный 32-битный RISC-процессор, способный обеспечить независимые соединения между 8192 оптическими каналами; в совместной разработке Колорадского университета и исследовательского института JILA (США) оптический нейрокомпьютер используется для распознавания человеческой речи), до сих пор появление самой машины в массовом производстве – лишь отдаленная перспектива. По мнению аналитиков, причина в том, что долгое время разработки в этой области были закрытыми. Соответственно, никто не занимался созданием оптического компьютера "для народа".

В 2009 году на международном симпозиуме PIERS 2009 (Progress in Electromagnetics Research Symposium) в Москве об этом виде компьютеров снова говорили лишь как о перспективе. "Фотонные кристаллы и метаматериалы могут послужить мощной базой для возникновения оптического компьютера. Чисто оптического компьютера, конечно, не будет, но оптические элементы в "памяти" будут популяризированы в самое ближайшее время. Так, на домашнем оптическом компьютере, который ничем внешне не будет отличаться от обычного, смогут храниться, например, все библиотеки мира", - сказал доктор ф.-м. наук, профессор, заведующий кафедрой ИБ РосНОУ, член-корреспондент РАН Сергей Никитов.

Еще один вариант развития компьютерной техники – молекулярный компьютер, размеры которого будут в тысячи раз меньше по объему при производительности, сравнимой с производительностью существующих кремниевых процессоров. В молекулярном компьютере вместо кремниевых чипов работают молекулы и молекулярные ансамбли. Но фундаментальные принципы построения новый компьютер должен унаследовать от классических ПК. В начале 2000-х гг. американский физик Джеймс Тур сказал: "Я не думаю, что новая технология полностью вытеснит кремний. Скорее всего, появятся гибридные кремний-молекулярные компьютеры, и это будет через пять-десять лет". Существовало и мнение, что массовое производство действующего молекулярного компьютера вполне может начаться где-нибудь между 2005 и 2015 гг. Но, несмотря на то, что сегодня многие технологии уже отработаны (транзисторы, модули памяти; среди последних разработок – в 2008 г. IBM создала молекулярный ключ, Международный центр для молодых ученых в Цукубе (ICYS) создал модель молекулярного процессора), до целого работающего молекулярного компьютера пока далеко. Причем чем ближе было к концу десятилетия, тем чаще это подчеркивалось в прогнозах ученых и аналитиков.

Виртуальная реальность пока нереальна

Другая идея, которая никак не может до конца осуществиться, несмотря на многочисленные разработки, это виртуальная реальность. В современном киберпространстве пока еще не достигнут эффект присутствия. И даже развитие 3D-технологий не позволяет оказаться внутри него, почувствовать запахи, вкусы, потрогать предметы виртуального мира. Проблема разработки ВР - в технологиях передачи информации. Есть два основных варианта "попадания" в мир ВР. Первый – это то, что можно назвать носимыми компьютерами или "умной одеждой" - шлем, перчатки, носимые дисплеи и прочие атрибуты; делались прогнозы вплоть до разработки вирутальных тел. Второй – подача информации прямо в мозг.

Оба направления развиваются постоянно. К 2005 году уже появились носимые дисплеи, похожие на очки. Изображение может передаваться пользователю двумя способами: формированием картинки на поверхности, находящейся перед глазами (маленький монитор), и его проецирование прямо на сетчатку. В 2006 году компания Konica Minolta продемонстрировала очки со встроенным дисплеем, основанным на принципе голографии. Изображение в новых видео-очках не заменяет реальную картинку, а накладывается поверх нее. В 2007 году компания Shimadzu запустила в продажу модель миниатюрного монокуляроного дисплея (всего 120 г) DataGlass, который к тому же является пыле- и водонепроницаемым. Также компания решила проблему разрядки аккумулятора носимого компьютера: гаджет питается через порт USB.

В 2010 году компания Brother Industries обещает выпустить носимый дисплей, проецирующий изображение на сетчатку глаза. Разработчикам удалось уменьшить размеры светопроекционного модуля (размеры нового модуля - 95×170×35 мм, что соответственно в 20 и в 13 раз меньше, чем у предыдущей версии), и наконец-то наголовный проекционный дисплей стал по-настоящему носимым – он весит всего 350 г. В отличие от наголовных мониторов, построенных на базе миниатюрных LCD-дисплеев, проекционный дисплей накладывает свою картинку на реальный мир, а не перекрывает его. Компания Vuzix в начале 2010 года анонсировала новую модель носимого дисплея, предназначенного для создания дополненной реальности Wrap 920AR. Это первый в мире бытовой наголовный дисплей с двумя экранами (видимый размер - 67 дюймов с расстояния в 3 метра) и парой стереокамер, изображение с которых транслируется на дисплеи. Каждая из камер передает видео с разрешением 752×480, 60 кадров в секунду. Два видео совмещаются в один стереопоток с разрешением 1504×480, он и воспроизводится дисплеем. Новинку ожидают в продаже не раньше середины года. Компания Kopin в 2010 году планирует выпустить носимый ПК, который надевается прямо на голову пользователя. Причем прибор будет посредником между настольным ПК и пользователем. Связь со стационарным ПК осуществляется через интернет (доступны WiFi, 3G или bluetooth для связи с телефоном). Носимый посредник передает данные со стационарного ПК на встроенный микродисплей, который будет казаться пользователю 15" монитором. Устройство поддерживает голосовое управление, а также управляется при помощи самой головы пользователя.

Однако многие эксперты относятся скептически к перспективе массового распространения носимых дисплеев в 2010 году. В прогнозе ведущих ИT-специалистов о новинках-2010, опубликованном британским изданием Daily Telegraph, сказано, что "очки, превращающие окружающую действительность в мир с постоянно встроенными цифровыми дополнениями, пока еще остаются прерогативой военных технологий".

Так и не появились к концу первого десятилетия 21 века устройства для "вхождения" в виртуальную реальность, действующие напрямую на мозг. В 2006 году американское издание Popular Science опубликовало итоги опроса ученых о том, какие высокотехнологичные изобретения войдут в нашу жизнь в течение ближайших 5-10 лет. Среди них были так называемые "мозговые курорты", когда благодаря специальному шлему с несколькими электромагнитными катушками можно совершать мысленные (умственные) путешествия. Суть устройства заключается в том, что прибор оказывает воздействие на кору головного мозга, периодически изменяя не только ход ее работы, но и ее строение, что позволяет сделать впечатления клиента от такого путешествия незабываемыми. К тому же эта процедура должна будет сопровождаться употреблением специальных препаратов, улучшающих память. По мнению ученых, такие "мозговые курорты" могут появиться ближе к 2015 году. Но после той публикации ни о данной технологии, ни о других, связанных с действием прямо на мозг и создающих таким образом ВР, слышно не было. Так что остается только ждать 2015 года, чтобы убедиться, что этот прогноз сбылся – или нет, как и все выше перечисленные.

Наталья Кузнецова