Обзор подготовлен

Русская зима повысит энергоэффективность ЦОДов?

С ростом масштаба российских ЦОД-проектов увеличивается значение рационального потребления электроэнергии, на которую приходится более половины операционных издержек дата-центров. Географическое положение России стимулирует применение энергосберегающих технологий с использованием холодного воздуха "с улицы", но распространению решений free cooling мешают высокие капитальные затраты при реализации таких проектов.

Потребность в ресурсах дата-центров продолжает расти, и уже сейчас на их долю приходится 1,5% промышленных выбросов парниковых газов. При этом в мире насчитывается не менее полумиллиона ЦОД. По данным Pike Research, при сохранении нынешнего тренда к 2016 г. на долю ЦОД придется 1326 млн тонн выбросов углекислого газа. Огромные потребности дата-центров связаны не только с требованиями самого ИТ-оборудования, но также с необходимостью охлаждать помещения, так как во время работы сервера выделяют много тепла. Кроме того, часть энергии теряется при транспортировке.

В современном ЦОД не менее 50% операционных затрат приходится на электроэнергию. При эксплуатации площадки в течение десяти лет расходы на электроэнергию составляют почти половину совокупной стоимости владения, поэтому вопрос рационального использования энергии в дата-центрах имеет не только экологический, но и экономический аспект.

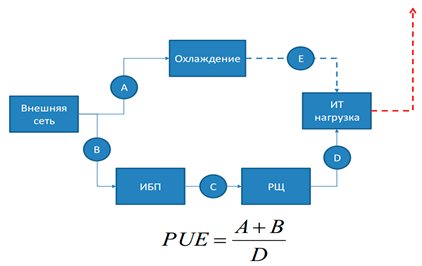

Для определения энергоэффективности в отрасли принято использовать два показателя: PUE и DCIE. Параметр PUE (Power Usage Effectiveness) определяется как отношение энергопотребностей ИТ-инфраструктуры ко всей энергии, поступающей в дата-центр. Идеальное значение PUE равно единице, в этом случае вся используемая площадкой энергия идет на поддержку работы серверов. На практике такая ситуация невозможна, минимальные значения PUE достигают около 1,1-1,15.

Что такое PUE?

Источник: APC by Schneider Electric, 2010

Аббревиатура DCIE расшифровывается как эффективность инфраструктуры дата-центра (Data Center Infrastructure Efficiency) и выражает в процентах то же самое, что и PUE.

Предел совершенства

Средний показатель энергоэффективности дата-центра в мире составляет около 2,5, о чем свидетельствуют данные EPA. Согласно исследованию Uptime Institute, cредний показатель PUE колеблется между 1,8 и 1,89, но эксперты этой организации обращают внимание на то, что в их статистике учитываются только крупные ЦОД, и если принять во внимание небольшие площадки, эффективность расходования энергии окажется существенно ниже. Опрошенные CNews эксперты сходятся в том, что в России средний показатель энергоэффективности также находится на уровне 1,8-2,5. При этом участники рынка обращают внимание на то, что заказчикам не следует гнаться за экстремально низкими показателями PUE.

"В среднем по миру показатель PUE для дата-центров TIER III составляет 1,98. А для TIER IV –больше 2. Это происходит, потому что на дата-центры накладываются дополнительные условия по резервированию и гарантированию бесперебойной работы, – рассказывает заместитель директора Сервисного подразделения "Ай-Теко" Дмитрий Митрофанов. – Можно сделать как Google: построить свою электростанцию и быть уверенным, что не будет колебаний напряжения - соответственно, сократить затраты на ИБП и уменьшить потребление энергии. Но мы в России пользуемся общими сетями и должны учитывать их особенности, в том числе их техническое несовершенство. Кроме того, нужно принимать во внимание особенности окружающей среды, например, в Москве и Московской области серьезным фактором риска для ЦОД является тополиный пух, поэтому нужны дополнительные затраты для защиты систем вентиляции. В эту же категорию попадают защита от кислотных дождей или от выбросов на мусоросжигательных заводах, и так далее".

Оценка значений PUE и DCIE

| Значение PUE | Значение DCIE | Оценка |

| 1,3 | 77% | Оптимальная организация ЦОД |

| 1,6 | 62,5% | Организация с учетом "лучших методов" |

| 2 | 50% | Есть возможность для улучшений |

| 3 | 33% | Меры для повышения PUE не предпринимаются |

Источник: The Green Grid Consortium, 2012

"На мой взгляд, коэффициент PUE должен быть неким компромиссом между энергоэффективностью и экономической целесообразностью, – говорит директор департамента инженерных систем "ЭнвижнГруп" Игорь Анисимов. – Да, строя ЦОД в "чистом поле", можно собрать технологии, которые обеспечат среднегодовой PUE на уровне 1,05 и ниже. Но пытаясь внедрить эти же технологии в ЦОДе, который размещается в малоприспособленном здании, можно натолкнуться на глобальное увеличение капитальных затрат, которые будут окупаться очень долго. Как правило, заказчику это неинтересно. К тому же PUE часто является не самым главным показателем для владельцев ЦОД. Во многих случаях гораздо важнее доступность, надежность и бесперебойность работы".

Какие технологии внедряются в России?

Тем не менее, российские интеграторы уже готовы строить ЦОД с показателями PUE cущественно более низкими, чем в среднем по рынку. Например, в компании "Техносерв" заявляют, что нормой является проектирование и строительство площадок с коэффициентом энергоэффективности 1,3.

"На наш взгляд, при проектировании новых ЦОДов в Москве можно ставить себе целью среднегодовой PUE 1.5, что вполне достижимо при современных технологиях холодоснабжения без применения революционных технических решений", – делится своим мнением технический директор DataLine Сергей Мищук.

Интерес к проблеме энергоэффективности связан с ростом масштаба проектов. "Лет 5-6 назад энергоэффективность в нашей стране мало кого волновала. С одной стороны, электроэнергия была достаточно дешевой, с другой - мощности большинства ЦОД измерялись десятками киловатт. Соответственно, затраты на энергоснабжение казались ничтожными по сравнению со стоимостью ИТ-оборудования, – объясняет директор департамента инженерных систем "Энвижн Груп" Игорь Анисимов. – Сейчас ситуация в корне изменилась: электричество дорожает, мощности дата-центров быстро растут. Например, сейчас мы проектируем в Москве ЦОД с мощностью ИТ-нагрузки 22,5 МВт. Очевидно, что при таких масштабах счета за электроэнергию ощутимо "ударят по карману" заказчика".

Первым шагом на пути снижения энергопотребления ЦОД является более рациональное использование ИТ-ресурсов за счет внедрения высокоплотных blade-серверов и технологий виртуализации. В результате сокращается объем работы дата-центра "вхолостую". "За счет использования технологии виртуализации и blade-систем, а также за счет балансировки нагрузки и активного управления приложениями можно сократить энергопотребление и тепловыделение основного оборудования на 10–20%, а это снижает энергозатраты и на охлаждение", – объясняет начальник отдела инженерных решений компании "Техносерв" Александр Перведенцев.

По его словам, основной идеей этого подхода является повышение загрузки оборудования без снижения качества услуг: "Простаивающий сервер тратит 15-30% от пиковой мощности абсолютно бесполезно. К этим пустым затратам добавляется нагрузка на систему охлаждения, блоки питания, систему резервирования и т.д. При использовании технологий виртуализации можно разместить на одном физическом сервере несколько виртуальных. При грамотном мониторинге нагрузки или при построении вычислительных кластеров (объединение нескольких серверов в одну вычислительную ячейку) можно повысить загрузку оборудования, сократив не только прямые экономические потери на простоях, но и холостое потребление энергии".

После оптимизации использования ресурсов наступает очередь модернизировать систему электропитания и охлаждения. Александр Перведенцев также отмечает следующие статьи сокращения издержек: "До 15% экономии электроэнергии позволяет получить выбор эффективной архитектуры кондиционирования помещения, до 12 % —правильная планировка машинных залов, до 10 % — выбор эффективного оборудования электропитания".

Изоляция горячих и холодных коридоров в ЦОДе

Источник: DataCenterForum, 2010

"Например, примененеие высокоэффективных теплообменников и насосов наряду с использованием двухконтурной системы позволяет добиться общей эффективности системы кондиционирования ЦОД на уровне 7-10 (показатель COP), то есть для производства 7-10 кВт холода затрачивается 1 кВт электроэнергии. При этом такого уровня эффективности можно добиться на классических технологиях без значительного удорожания системы кондиционирования ЦОД. Что касается эффективной системы бесперебойного снабжения, то КПД динамических дизельных ИБП доходит до 96-97%".

"Третьим фактором, способствующим снижению PUE, является тщательно спроектированная автоматическая система управления (АСУ) объекта, которая позволяет устранить неэффективность в работе оборудования, например, поддерживать минимально допустимые параметры влажности в ЦОД, сокращая затраты электроэнергии на увлажнение, или минимизировать расход жидкости при уменьшении нагрузки", – рассказывает господин Перведенцев.

Есть множество других решений, которые позволяют повысить энергоэффектиность ЦОД. Например, это nригенерация – комбинированное производство электричества, тепла и холода. При этом холод вырабатывается абсорбционной холодильной машиной, потребляющей не электрическую, а тепловую энергию. Электрическую и тепловую энергию в этой системе производит микротурбинная установка, работающая на газе. Кроме того, можно спроектировать "горячие" и "холодные" коридоры (разделение потоков воздуха разной температуры), построить систему адиабатического охлаждения (за счет испарения, это удобно, если есть много дешевой пресной воды). Наконец, можно сократить затраты на энергию просто повысив температуру в серверном помещении: последние испытания показывают, что современное оборудование устойчиво к работе при температурах выше 25, а иногда и 30 градусов. Еще один вариант, который пока кажется экзотическим для России, это сбор тепла, выделяемого серверами, и его продажа вовне.

При использовании стандартных решений снизить PUE вполне возможно до 1,3, подводит итог ведущий консультант департамента системных решений IBS Константин Зиновьев.

Холодный климат поможет сэкономить энергию

Из современных энергосберегающих технологий наиболее перспективной для использования представляется система естественного кондиционирования free cooling, когда помещение охлаждается за счет холодного воздуха снаружи. Очевидно, что большая часть территории России представляет собой отличное место для внедрения таких разработок.

"У технологии free cooling есть хорошие перспективы в России, – утверждает заместитель директора департамента строительства и инженерных систем "Яндекса" Сергей Куприн. – У нас достаточно холодный климат в средней и северной полосе, что позволяет большую часть года использовать для охлаждения наружный воздух". "В российских климатических условиях данная технология очень перспективна, ее надо внедрять как можно активнее", – уверен Игорь Анисимов. По его оценкам, "фрикулинг" уже используется достаточно широко, и во многих ЦОДах, появившихся в России за последние 3-4 года, применяется та или иная его модификация (прямой, косвенный и т.д.).

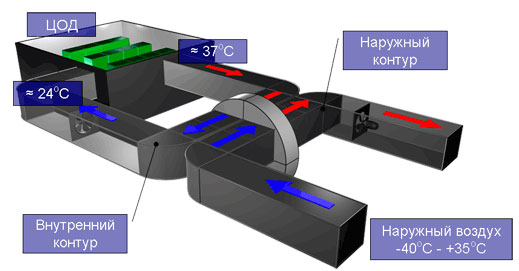

Устройство системы Full free cooling (FFC)

Источник: AyaksEngineering, 2012

Тем не менее, другие эксперты, опрошенные CNews, говорят о том, что проектов с применением free cooling в России пока мало, и это связано с тем, что внедрение подобных систем значительно увеличивает капитальные затраты. "Нельзя сбрасывать со счетов тот факт, что система холодоснабжения с "фрикулингом" обычно оказывается существенно сложнее системы без него, что требует более высокой квалификации при проектировании, монтаже, настройке и на этапе эксплуатации, – объясняет Сергей Мищук. – Опыт создания систем с "фрикулингом" в России пока невелик, поэтому есть большая вероятность инженерных ошибок на любом этапе жизненного цикла. В результате фактическая эффективность системы может оказаться существенно хуже проектной, что снизит экономическую отдачу от вложений".

"Применение free cooling, во-первых, требует заметного увеличения первоначальных затрат на строительство ЦОД – до 100% и более – констатирует Сергей Куприн из "Яндекса", который одним из первых в России реализовал подобный проект. – Во-вторых, российские компании редко планируют проекты ЦОДов со сроком эксплуатации более 5 лет. Как правило, в среднесрочной перспективе такие технологии не окупаются. Ну а в-третьих, технологии free cooling чаще используются на масштабных и долгосрочных проектах, когда компания-владелец строит ЦОД мощностью в несколько десятков или сотен МВт. У нас пока практически нет таких проектов".

"Системы с роторным рекуператором (подобная система внедрена в подмосковном ЦОД "Яндекса", прим. CNews) требуют много места, объем помещений увеличивается раза в полтора, что не всегда экономически приемлемо, особенно в городе, а подавляющее большинство российских ЦОДов находятся в крупных городах", – рассказывает Сергей Мищук. По его словам, вариант "фрикулинга" с подмешиванием внешнего воздуха также не эффективен в условиях большого города, потому что требуется много места для вентиляционных камер, а также необходимы затраты на очистку городского воздуха и его увлажнение зимой.

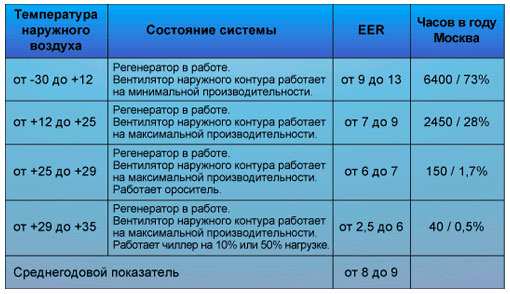

Показатели работы системы FFC*

* показатель EERпоказывает эффективность работы кондиционера и определяется как отношение количество потребляемой электроэнергии к "количеству охлаждения"

Источник: AyaksEngineering, 2012

"Если за базовый вариант брать схему с прямым расширением, а в качестве энергоэффективного рассматривать "чиллерную" схему с "фрикулингом", то второй вариант холодоснабжения обойдется раза в два дороже, – объясняет Сергей Мищук. – Срок окупаемости вложений в этом случае, по нашим расчетам, составляет 3-5 лет. Есть интересные идеи по снижению стоимости свободного охлаждения, которые, по нашим оценкам, обеспечат возврат инвестиций во "фрикулинг" за 2-3 года, но они пока не проверены нами на практике и их реализация связана с существенным экономическим риском".

В "Яндексе" считают, что энергосберегающие технологии окупаются только в случае долгосрочных проектов со сроком эксплуатации ЦОД более 10 лет. Другого мнения придерживается Александр Перведенцев: по его словам, при загрузке ЦОД более 60% максимальная окупаемость будет не более трех лет. Константин Зиновьев предлагает следующую формулу для расчета эффективности использования энергосберегающих технологий при сроке окупаемости 10 лет: "Решение окупается, если достигнуто снижение PUE на 0,05 и при этом цена создания ЦОД не выросла более чем на 5%".

Стоимость внедрения free cooling cильно зависит от характера помещения ЦОДа. "Если нужно разместить дата-центр в готовом помещении, мы сильно ограничены в выборе инженерных решений, и обеспечить высокую энергоэффективность вряд ли удастся. Если же мы строим ЦОД "с нуля", обычно мы можем влиять на параметры помещения: обеспечить большие проемы, вентиляционные шахты и т.д. Зачастую это проще и дешевле, чем "вписываться" в готовое здание",– рассказывает Игорь Анисимов. По его словам, нижняя планка затрат на "фрикулинг" составляет 10-15% общей суммы строительства ЦОД, а верхний предел "ограничен только фантазией исполнителя".

Павел Лебедев/CNewsAnalytics